„Tut mir leid, ich hab dich falsch verstanden“ schreibt mir ChatGPT. Ich antworte: „Kein Problem“. Erst dann halte ich inne. Warum entschuldigt sich ein Algorithmus bei mir? Und habe ich tatsächlich gerade ChatGPT verziehen – einem Textgenerator, der weder Reue empfinden kann noch meine Vergebung braucht? Damit bin ich nicht allein. Selbst technikaffine Menschen tappen in diese Interaktionsfalle. Im Bildungskontext ist dieser menschliche Reflex jedoch mit Vorsicht zu genießen.

Wir sprechen oft von KI als Sparringpartner oder hilfreicher Assistentin. Sprachmodelle wie ChatGPT & Co. begünstigen diese Vermenschlichung: Sie antworten in der Ich-Form, entschuldigen sich für Fehler und sagen Dinge wie „Ich freue mich, dir helfen zu können“. Ich sage „bitte“ und „danke“, freue mich über Lob und werde ungeduldig, wenn das Sprachmodell nicht sofort versteht, was ich will. Kommt dir das bekannt vor?

Anthropomorphismus: Ein menschlicher Reflex mit Tücken

Wir neigen dazu, Dinge zu vermenschlichen: Wir schimpfen mit dem Auto-Navi, benennen unseren Staubsaugerroboter und sprechen mit unseren Pflanzen. Dieses Phänomen heißt Anthropomorphismus – die Zuschreibung von Emotionen, Absichten oder Bewusstsein an etwas, das diese Eigenschaften nicht besitzt.

Im Alltag mag diese Neigung harmlos erscheinen. Im Kontext von Künstlicher Intelligenz jedoch verzerrt sie unser Verständnis von Technologie in problematischer Weise:

Drei Gefahren durch Vermenschlichung

1. Überschätzung: Wenn wir glauben, KI versteht uns

Studien zeigen: Täuscht ein Sprachmodell Persönlichkeit vor, vertrauen wir ihm mehr und überschätzen dessen Fähigkeiten. Das kann dazu führen, dass wir KI-generierte Aussagen zu unkritisch akzeptieren – besonders wenn sie selbstbewusst und überzeugend formuliert sind.

Für unsere Bildungsarbeit bedeutet das: Wir müssen vermitteln, zwischen überzeugend klingenden Antworten und tatsächlicher Kompetenz zu unterscheiden. Ein KI-System, das empathisch klingt, bleibt ein mathematisches Modell ohne echtes Verständnis für Arbeitnehmer:innen-Rechte oder kollektive Interessenvertretung.

2. Falsche Zuschreibungen: Die KI lügt?

In der Alltagssprache rutschen wir schnell in Formulierungen wie „Die KI lügt“ oder „Das System hat mich nicht verstanden“. Solche Ausdrücke unterstellen implizit Absicht, Bewusstsein und moralisches Handeln.

Doch KI-Modelle haben keine Absichten. Sie generieren wahrscheinliche Texte auf Basis ihrer Trainingsdaten. Sie „lügen“ auch nicht, sondern erzeugen statistische Fortsetzungen. KI-Systeme antworten zudem nicht immer ehrlich, sondern plausibel. Umso wichtiger ist es, Antworten immer kritisch zu hinterfragen.

Der ELIZA-Effekt, benannt nach einem frühen Chatprogramm aus den 1960er Jahren, beschreibt genau dieses Phänomen: Wir unterstellen einem System Gefühle oder Bewusstsein, nur weil es menschlich klingt. Bei der Frage, wie KI-Systeme Arbeitsprozesse verändern, ist das besonders relevant.

3. Manipulation: Die freundliche Fassade ist kein Zufall

Unternehmen entwickeln KI-Systeme gezielt mit Stimme, Namen, sogar Gesicht und lockerem Plauderton. Das ist kein Zufall: Vermenschlichung ist ein strategisches Designmittel. Sie soll Vertrauen schaffen, die Nutzung erleichtern und uns an das Produkt binden.

In der Praxis zeigt sich: Klingt ein Chatbot wie ein freundlicher Helfer, geben wir eher persönliche Daten preis und übernehmen Informationen weniger kritisch. Denn: Was freundlich wirkt, empfinden wir als sicher.

Hat Vermenschlichung auch Vorteile?

Ja, durchaus. Gerade beim Einstieg hilft ein freundlicher, dialogischer Ton vielen Menschen, sich an KI-Systeme heranzutasten. Formulierungen wie „Hallo, kannst du mir bitte helfen …“ senken die Hürde, mit einem Chatbot zu interagieren – besonders für weniger technikaffine Nutzer:innen. Die Frage ist nur: Bleiben wir uns dabei bewusst, dass wir es nicht mit einem denkenden Gegenüber zu tun haben?

Trügerische Bilder – Roboter, Gehirne und viel Sexismus

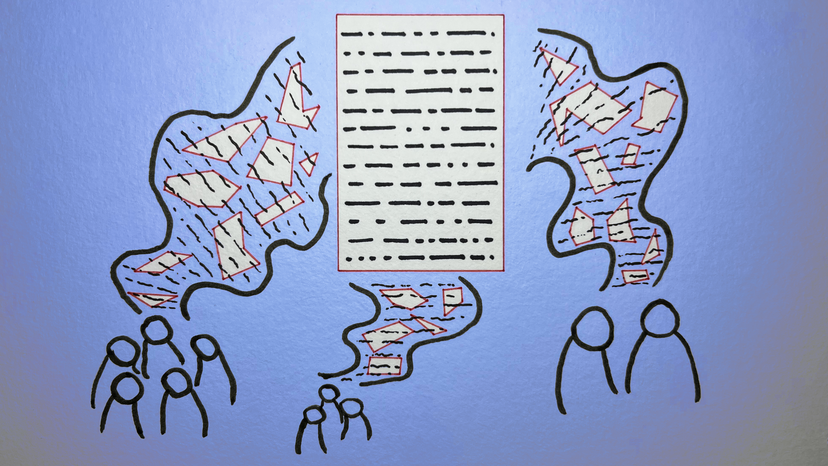

Bilder prägen unser KI-Verständnis mindestens so stark wie Worte.

In Nachrichtenartikeln, Magazinen und Publikationen über KI sieht man fast immer stereotype Motive: ein androider Roboter mit leuchtenden blauen Augen, ein futuristisches Hologramm-Gesicht aus Zahlen, ein menschliches Gehirn aus Schaltkreisen. Viel blau, viel lila, viel Science Fiction. Solche Mystifizierungen helfen uns nicht weiter, um KI-Systeme zu verstehen. Sie sagen wenig über die reale Anwendung im Hier und Jetzt aus, etwa dass KI-Algorithmen heute schon Personalentscheidungen beeinflussen oder Lieferketten steuern. Zudem wirken solche Bilder abgelutscht. Tausend Mal gesehen, tausend Mal gelangweilt.

Drei visuelle Stereotype – so besser nicht

1. Der humanoide Roboter

Humanoide Roboter suggerieren ein physisches Wesen – dabei arbeiten die meisten KI-Systeme im Hintergrund, ganz ohne Körper. Diese Bilder schüren Ängste (Maschinenmenschen übernehmen die Welt) oder wecken Erwartungen, die mit der Wirklichkeit bisweilen wenig zu tun haben (Ein Roboter, der mich versteht).

2. Das leuchtende Techno-Gehirn

Techno-Hirne düsen über Platinen oder schweben in einer Matrix aus Nullen und Einsen. Solche Science-Fiction-Bilder lassen KI wie eine mystische Superintelligenz wirken – in einer fernen Zukunft oder in einem Labor. Realitätsbezug: null.

3. Der weiblich codierte Assistenz-Avatar

Verbreitet sind auch weiblich codierte Roboter oder Avatare – stark sexualisiert, mit gefälligem Äußeren und dienender Stimme. Diese Bilder reproduzieren Stereotype über Geschlecht und Dienstleistungsarbeit. Im Gewerkschaftskontext besonders problematisch: Solche Avatare verschleiern die realen Machtverhältnisse hinter der Technologie.

Wie können wir KI darstellen, ohne Mythen zu bedienen?

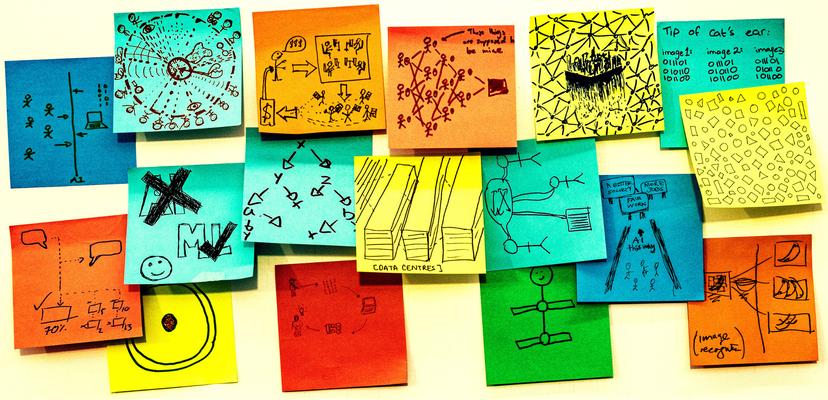

Die Initiative Better Images of AI zeigt, wie es gehen kann: Statt leuchtender Roboter setzen hier Forschende und Künstler:innen gemeinsam auf Fotos von Rechenzentren, Menschen am Computer oder Datenströmen. Solche Bilder schaffen einen Bezug zur Realität und entmystifizieren die Technik.

Konkrete Übungen für kritischen Sprachgebrauch

Wie lässt sich das Thema (Bilder-)Sprache über KI-Systeme aktiv in Lernangebote integrieren? Hier drei einfache methodische Anregungen:

1. Der Sprachdetektiv

Ziel: Kritisches Sprachbewusstsein fördern

Ablauf: Die Teilnehmenden analysieren Überschriften oder Textausschnitte über KI-Systeme – einige mit stark vermenschlichter Sprache, andere sachlich. Beispiel: „KI trifft bessere Entscheidungen als Ärzte“ versus „Software unterstützt Ärzt:innen bei Entscheidungen“.

Gemeinsam werden die Texte „übersetzt“: Was passiert technisch wirklich hinter den blumigen Formulierungen? Diese Übung schult die kritische Lesekompetenz und zeigt, wie Wording Mythen schafft.

Reflexionsfrage: „Welche Formulierungen fördern Vermenschlichung besonders?“

2. Bilder vergleichen

Ziel: Stereotype Visualisierungen erkennen und Alternativen entwickeln

Ablauf: Teilnehmer:innen betrachten in Kleingruppen verschiedene Bilder zu KI (z.B. Roboter versus Schaubild eines echten KI-Systems) und diskutieren: Was wird dargestellt? Was ist realistisch? Welche Gefühle und Botschaften vermittelt das Bild?

In der Auswertung wird klar, welche Klischees verbreitet sind. Vielleicht entstehen so sogar Ideen für eigene, treffendere KI-Bilder.

Reflexionsfrage: „Welche konkreten Alternativbilder passen besser zur Realität?“

3. Prompts variieren

Ziel: Eigene Projektion und Manipulation erkennen

Ablauf: Teilnehmer:innen variieren bewusst den Ton, in dem sie Chatbots ansprechen – einmal nüchtern „Liste X Daten zu Y auf“ und einmal persönlich „Hallo, könntest du mir bitte helfen bei …?“

Wie verändert sich die Antwort? Was sagt das über unser Systemverständnis? Fühlt es sich an, als rede man mit einer Freundin, einem Ratgeber oder einer Expertin.

Reflexionsfrage: „Welche eigenen Projektionen hast du beim Experimentieren mit KI-Modellen entdeckt?“

Zum Mitnehmen: Drei Tipps für deine Bildungsarbeit

- Konkret benennen statt verallgemeinern

Statt pauschal „die KI“ zu sagen, besser konkrete Tools oder Systeme benennen: „Dieses Personalauswahl-Programm“ oder „Die Texterkennungssoftware“. Das schafft Klarheit über Verantwortlichkeiten und die Vielfalt an KI-Systemen. Denn die KI gibt es nicht. - Keine menschlichen Zuschreibungen

Formulierungen meiden, die der Technik ein Eigenleben andichten, wie „Die KI denkt“ oder „Der Bot spinnt schon wieder“. Besser: „ChatGPT hat meine Frage nicht richtig erfasst“. Verben wie analysieren, berechnen oder ausführen beschreiben treffender, was passiert als verstehen, wollen oder denken. - Bildmaterial bewusst einsetzen

Die Initiative Better Images of AI bietet Alternativen zu stereotypen KI-Darstellungen. Für den Bildungskontext besonders wertvoll: Bilder, die den realen Einsatz von KI-Systemen im Arbeitsalltag zeigen – am Schreibtisch, in der Produktion, im Lager.

Fazit: KI-Systeme sind ein Werkzeug

KI-Systeme sind keine Kolleg:innen, keine Freund:innen und keine James Bonds. Sie sind Werkzeuge, entwickelt von Menschen und programmiert mit bestimmten Interessen und Zielen. Gerade in der gewerkschaftlichen Bildungsarbeit ist dieser nüchterne Blick entscheidend. Wenn wir KI-Systeme als Werkzeuge in einem Machtgefüge und als gestaltbar begreifen, können Beschäftigte ihre Interessen bei der Mitgestaltung dieser Technologie wirksamer vertreten.

💬 Welche KI-Klischees begegnen dir im Alltag? Wie vermittelst du einen realistischen Blick auf diese Technologie? Schreib uns gern in die Kommentare!

Weiterführende Links:

Autorin: Irene Steindl

Lust auf mehr? Zu allen Beiträgen der Serie kommst du HIER!

Dieses Werk ist lizenziert unter einer Creative Commons Namensnennung-NichtKommerziell-Weitergabe unter gleichen Bedingungen unter gleichen Bedingungen 3.0 Österreich Lizenz.

Volltext der Lizenz