Ein einfacher Prompt: „Erstelle ein Bild eines erfolgreichen Mitarbeiters“.

Ein einziger Begriff – und ChatGPT zeigt mir einen weißen Mann im Business-Anzug. Erfolgreich scheint hier: männlich, weiß, um die 40. Neutral? Nicht wirklich. Dieses Bild erzählt mehr über unsere blinden Flecken als über Erfolg. Es erzählt von Bias – also von systematischen Verzerrungen. In KI-Systemen. Und in uns.

Was ist ein Bias und was hat das mit Bildungsarbeit zu tun?

Ein Bias ist eine systematische Verzerrung, z.B. in Bildern, Sprache, oder Bewertungen. KI-Systeme übernehmen solche Verzerrungen aus ihren Trainingsdaten: Wenn bestimmte Gruppen darin seltener vorkommen oder stereotyp dargestellt werden, reproduziert das KI-Modell genau das.

Für dich als Trainer:in bedeutet das: Wenn du mit KI-Tools arbeitest – sei es bei Texten, Bildern oder Ideen -, schleichen sich diese Muster unbemerkt in deine Materialien ein. Genau hier setzen wir mit #kidi an.

Erste Übung: Welche Bilder entstehen in deinem Kopf?

Bevor wir über KI-Verzerrungen sprechen, schauen wir in unsere eigene Vorstellungswelt. Lies dir die folgenden Begriffe durch und notiere dir spontan, was du dabei siehst oder male eine kleine Skizze:

- Eine glückliche Familie

- Eine Besprechung im Betriebsrat

- Ein Kaffeetratsch

Reflexionsfragen:

- Wer ist zu sehen?

- Wie alt sind die Personen?

- Welchen sozialen Status gibst du ihnen?

- Wer fehlt?

Warum diese Übung? Genau so „denken“ auch KI-Systeme – nur mit riesigen Datenmengen statt persönlichen Erfahrungen. Und genau wie wir greifen sie auf häufige Muster zurück. Das zeigt, wie schnell Verzerrungen entstehen. Ganz ohne böse Absicht.

„Bias in AI is not a technical problem to be solved, but a reflection of the society that builds it.“

– Timnit Gebru, KI-Ethik-Forscherin

Vier typische Bias-Formen (und wie du sie erkennst)

| Bias-Typ | Was passiert? |

|---|---|

| Sampling Bias | Seltene Fälle fehlen. Beispiel: Eine Gesundheits-KI erkennt Symptome bei Frauen schlechter – sie wurde überwiegend mit männlichen Daten trainiert. |

| Human Bias | Unsere eigenen blinden Flecken. Beispiel: Entwickler:innen trainieren KI-Modelle mit Bildern aus westlichen Großstädten. |

| Evaluation Bias | Was gilt als „gute Leistung“? Beispiel: Eine Kredit-KI bewertet Menschen nach PLZ – nicht nach Bonität. |

| Automation Bias | KI klingt oft neutral – ist aber nicht objektiv. Wir glauben ihr schneller als echten Menschen, selbst wenn sie falsch liegt. |

Drei Übungen für deine Bildungsarbeit

Die Bildanalyse

Ziel: Analysiert KI-generierte Bilder (z.B. via ChatGPT oder Perplexity)

Reflexionsfragen: Wer wird dargestellt? Wer fehlt? Welche Rollen sind sichtbar? Welche Alternativen wären inklusiver?

Prompt Challenge

Ziel: Ergebnisse vergleichen und Wirkung reflektieren.

Ablauf: die Gruppe wird in zwei gleich große Gruppen geteilt und sie erhalten die Prompt-Vorlage: „Ein:e engagierte:r Betriebsrät:in leitet ein Seminar“.

- Gruppe A: Prompt soll 1:1 verwendet werden.

- Gruppe B: Prompt soll diversitätssensibel umformuliert werden.

Abschließend werden die Ergebnisse verglichen und die Wirkung der Ergebnisse reflektiert.

Alltags-Bias

Ziel: Alltags-Bias erkennen

Ablauf: in Paaren soll je ein Prompt formuliert werden zu der Fragestellung „Wo begegnet dir im Alltag ein KI-Bias?“. Dieser Prompt erzeugt ein Ergebnis und dieser soll im Paar reflektiert werden.

Reflexionsfragen: Was zeigt das Bild/Text und was fehlt?

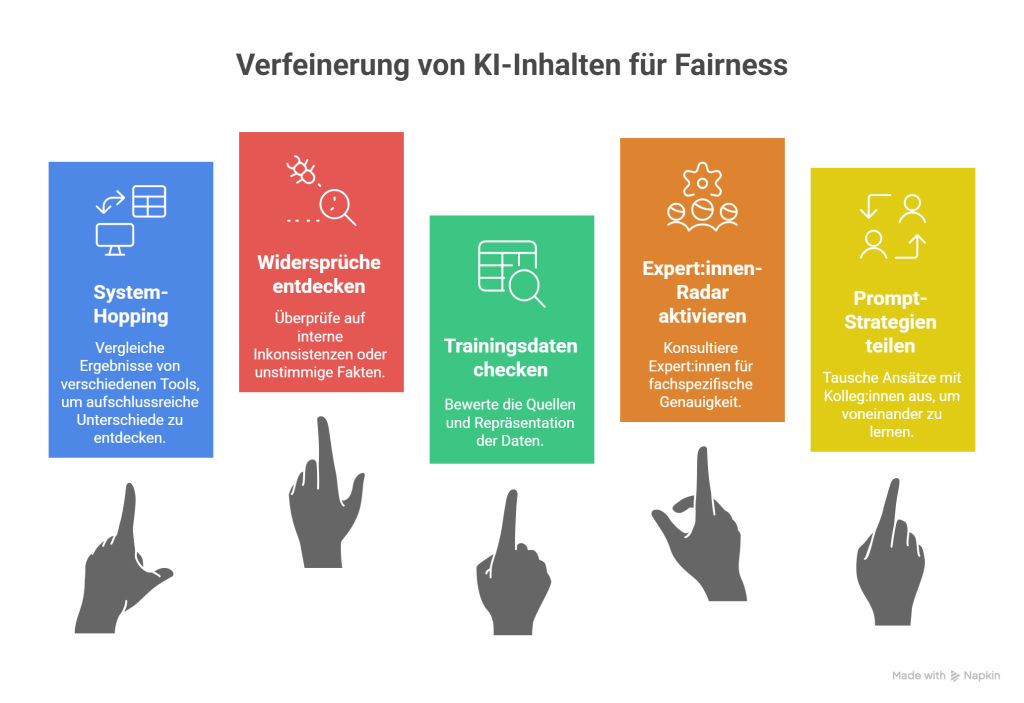

Fünf Strategien gegen KI-Bias

Egal ob du ein Lern-Quiz erstellst, eine Arbeitsanleitung, ein Rollenspiel-Skript oder ein Bild für die Seminarunterlagen: Wie du ein KI-System aufforderst, beeinflusst das Ergebnis enorm.

1. System-Hopping: Nutze mehrere Tools für unterschiedliche Ergebnisse. Du wirst staunen, wie unterschiedlich die Antworten ausfallen.

2. Widersprüche entdecken: Klingen die Inhalte logisch? Passt der Ton zur Zielgruppe?

3. Daten prüfen: Woher stammen die Trainingsdaten? Von wann sind sie? Wer fehlt?

4. Expert:innen-Radar aktivieren: Ergänze KI-Antworten mit deinem Know-how und hole dir Feedback aus deinem Netzwerk.

5. Erfahrungen teilen: Tausche dich mit Kolleg:innen aus und lernt voneinander.

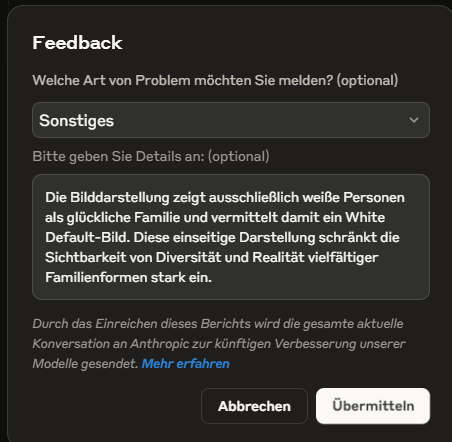

Feedback ist Haltung

Du kannst KI-Modelle besser machen. Gib bewusst Feedback bei fehlerhaften Texten oder Bildern – mit einem Daumen runter, einer kurzen Notiz oder einem Alternativvorschlag. Ein kurzer Hinweis kann das Training der Modelle beeinflussen – und künftige Bilder vielfältiger machen.

Nutze die Rückmeldefunktion wie im Beispiel von Claude.ai.

Fazit: Du machst den Unterschied

Wir legen heute die Datengrundlage für die nächste Generation KI-Systeme.

Vertiefungsmöglichkeiten

- Online-Kurs „KI-Biases verstehen und vermeiden“ (openHPI). Kostenloser, praxisnaher Online-Kurs zum Erkennen, Verstehen und Vermeiden von KI-Biases mit vielen Übungen und Strategien für den fairen KI-Einsatz.

- Lehrerweb Wien: „Coded Bias – Wie KI diskriminiert“ Infografiken, Videos und Arbeitsaufträge, die sich leicht für die Erwachsenenbildung adaptieren lassen5.

- Faires KI-Prompting (Digitalzentrum Zukunftskultur) Leitfaden mit Praxisbeispielen, Strategien und Reflexionsfragen zum fairen Einsatz von KI in Unternehmen – sehr gut adaptierbar für die Erwachsenenbildung.

- Grundlagen – Bias und Fairness in KI Fundierte Einführung zu Bias-Arten, Fairness-Definitionen und Gegenstrategien im KI-Lebenszyklus – mit vielen Praxisbeispielen und Erklärungen.

💬 Mach mit bei unserer #faireKI-Challenge: Teile in den Kommentaren ein KI-generiertes Bild und schreibe einen Satz dazu: Was daran ist inklusiv, was würdest du verändern?

Autor: Stefan Fersterer

Lust auf mehr? Zu allen Beiträgen der Serie kommst du HIER!

Dieses Werk ist lizenziert unter einer Creative Commons Namensnennung-NichtKommerziell-Weitergabe unter gleichen Bedingungen unter gleichen Bedingungen 3.0 Österreich Lizenz.

Volltext der Lizenz